Hướng dẫn tạo file robots.txt cho website WordPress

Khi bạn khởi đầu một chiến dịch SEO onpage, thì chắc rằng bạn đã từng nghe qua về việc tạo file robots.txt để tương hỗ hoặc ngăn ngừa những công cụ tìm kiếm website của mình. Trong bài này, tôi sẽ hướng dẫn cách bạn tạo ra file robots.txt bằng Yoast SEO và cách để khai thác file robots.txt triệt để nhất cho SEO .

File robots.txt là gì?

Trước tiên, bạn cần biết làm thế nào những công cụ tìm kiếm tích lũy được tài liệu từ website của bạn. Đó là nhờ những con bots tự động hóa được tạo ra từ những thuật toán vô cùng phúc tạp. Những bot này thu thập dữ liệu trên mạng để giúp những công cụ tìm kiếm như Google lập chỉ mục và xếp hạng hàng tỷ trang trên Internet .

Hầu hết các website sẽ được thiết lập index toàn bộ website, những tài nguyên trên website được index sẽ hiển thị trên google mỗi khi người nào đó tìm kiếm những từ khóa liên quan về nó.

Bạn sẽ không thích những thư mục, tài nguyên nhạy cảm của website được tích lũy và công khai minh bạch trên những công cụ tìm kiếm, nó sẽ chứa rất nhiều rủi ro đáng tiếc về bảo mật thông tin .Như vậy, file robots.txt được sinh ra đưa ra những hướng dẫn cho những bots của những công cụ tìm kiếm, đâu là nơi bạn nên đến và không nên đến để thu thập dữ liệu .

Tại sao bạn nên quan tâm đến tệp Robots.txt của mình?

Đối với hầu hết những quản trị web, quyền lợi của tệp robot.txt có cấu trúc tốt thường sẽ có hai công dụng chính sau :

- Tối ưu hóa tài nguyên thu thập dữ liệu của các công cụ tìm kiếm bằng cách nói với họ đừng lãng phí thời gian trên các trang mà bạn không muốn được lập chỉ mục. Điều này giúp đảm bảo rằng các công cụ tìm kiếm tập trung vào việc thu thập dữ liệu các trang mà bạn quan tâm nhất.

- Tối ưu hóa việc sử dụng máy chủ của bạn bằng cách chặn các bot đang lãng phí tài nguyên. Nhiều trường hợp website gặp tình trạng chậm, lag do hosting/máy chủ phải cung cấp tài nguyên để phản hồi các request từ các bots.

Tạo file robots.txt trên website WordPress như thế nào?

Có nhiều cách đê tạo ra file này, một cách đơn thuần là sử dụng plugin Yoast SEO – Plugin tối ưu SEO tổng hợp. Ngoài việc tương hỗ tạo nhanh robots.txt thì bạn hoàn toàn có thể tìm hiểu và khám phá thêm những tính năng SEO vô cung có ích từ Yoast SEO .

Tại giao diện quản trị website (Dashboard) → Plugins → Add new. Bạn có thể download plugin Yoast SEO miễn phí tại đây hoặc tìm kiếm trong kho thư viện của WordPress với từ khóa “Yoast SEO” và tiến hành cài đặt vào website.

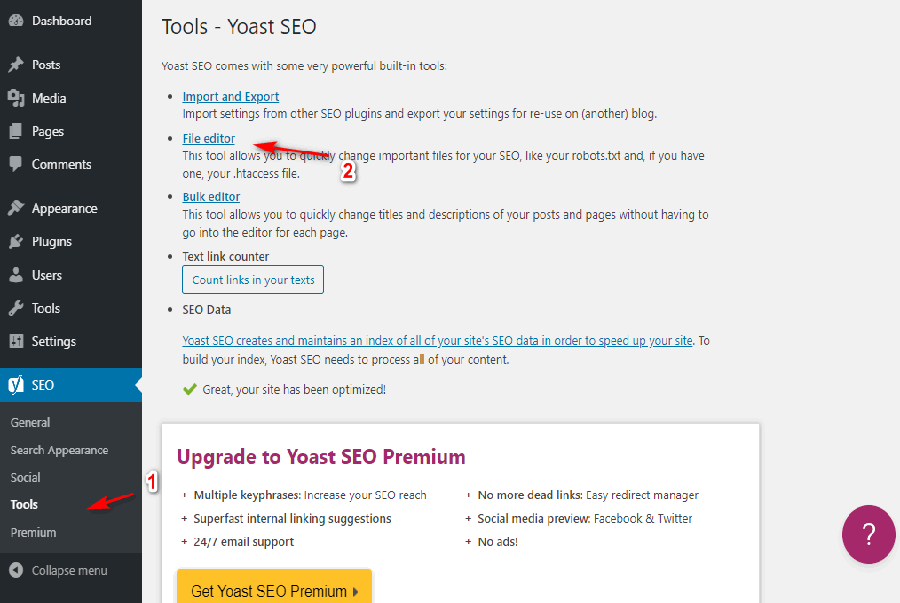

Tại SEO → Tools.

Nhấn chọn File Editor, tiếp tục nhấn Lưu thay đổi vào robots.txt để hoàn tất quá trình tạo file hoặc chỉnh sửa robots.txt.

Làm sao để kiểm tra file Robots.txt?

Bạn có thể kiểm tra tệp Robots.txt của bạn bằng công cụ Robots.txt tester của Google. Chỉ cần nhấp vào Please select a property, và chọn website của bạn, Google sẽ hiển thị công cụ kiểm tra hoạt động file robots.txt.

Bạn hoàn toàn có thể điền bất kể URL nào, gồm có cả trang chủ của bạn. Bạn sẽ thấy một màu xanh lá cây tức là mọi thứ hoàn toàn có thể thu thập dữ liệu. Bạn cũng hoàn toàn có thể kiểm tra những URL bạn đã chặn để bảo vệ chúng thực sự bị chặn và không được phép tích lũy thập dữ liệu .

Bạn hoàn toàn có thể điền bất kể URL nào, gồm có cả trang chủ của bạn. Bạn sẽ thấy một màu xanh lá cây tức là mọi thứ hoàn toàn có thể thu thập dữ liệu. Bạn cũng hoàn toàn có thể kiểm tra những URL bạn đã chặn để bảo vệ chúng thực sự bị chặn và không được phép tích lũy thập dữ liệu .

Tùy chỉnh file Robots.txt nâng cao

Nếu bạn chỉ cần tạo một file robots.txt đơn thuần, thì đây là toàn bộ, nếu bạn muốn hiểu sâu xa về cách thao tác và cách tối ưu file robots.txt thì hãy tìm hiểu thêm tiếp những hướng dẫn dưới đây .

Robots.txt có chặn hoàn toàn việc các công cụ tìm kiếm lập chỉ mục.

Robots. txt không phải là một cách thuận tiện để trấn áp những trang công cụ tìm kiếm lập chỉ mục. Nếu tiềm năng chính của bạn là ngăn những trang nhất định không được đưa vào hiệu quả của công cụ tìm kiếm, cách tiếp cận tương thích là sử dụng thẻ meta noindex hoặc một giải pháp trực tiếp tựa như khác .Điều này là do Robots. txt của bạn không trực tiếp nhu yếu những công cụ tìm kiếm không lập chỉ mục nội dung – nó chỉ bảo họ không thu thập dữ liệu. Mặc dù Google sẽ không thu thập dữ liệu những khu vực được ghi lại từ bên trong website của bạn, nhưng chính Google công bố rằng nếu một website bên ngoài link đến một trang mà bạn loại trừ với tệp Robots. txt của bạn, Google vẫn hoàn toàn có thể lập chỉ mục trang đó .John Mueller, Nhà nghiên cứu và phân tích quản trị website của Google, cũng đã xác nhận rằng nếu một trang có những link được trỏ đến nó, ngay cả khi nó bị chặn bởi tệp robots.txt, vẫn hoàn toàn có thể được lập chỉ mục .

Trong tệp Robots.txt của bạn có gì?

Được rồi, bây giờ bạn có tệp robot.txt vật lý trên máy chủ của mình mà bạn có thể chỉnh sửa khi cần. Nhưng bạn thực sự làm gì với tập tin đó? Chà, như bạn đã học trong phần đầu tiên, robot.txt cho phép bạn kiểm soát cách robot tương tác với trang web của bạn. Bạn làm điều đó với hai lệnh cốt lõi:

Xem thêm: Khoa học máy tính – Wikipedia tiếng Việt

- User-agent – điều này cho phép bạn nhắm mục tiêu các bot cụ thể. User-agent là những gì bot sử dụng để nhận dạng chính họ. Với User-agent, ví dụ, bạn có thể tạo quy tắc áp dụng cho Bing, nhưng không áp dụng cho Google.

- Disallow – điều này cho phép bạn nói với robot không truy cập vào các khu vực nhất định trên trang web của bạn.

Ngoài ra còn có một lệnh Allow mà bạn sẽ sử dụng trong các tình huống thích hợp. Theo mặc định, mọi thứ trên trang web của bạn được đánh dấu bằng Allow , do đó không cần thiết phải sử dụng lệnh Allow trong 99% tình huống. Nhưng nó có ích khi bạn muốn Disallow truy cập vào một thư mục và các thư mục con của nó nhưng Allow truy cập vào một thư mục con cụ thể.

Trước tiên, bạn thêm quy tắc bằng cách chỉ định User-agent nào nên áp dụng quy tắc và sau đó liệt kê các quy tắc sẽ áp dụng bằng Disallow và Allow. Ngoài ra còn có một số lệnh khác như Crawl-delay và Sitemap sẽ có những tác động sau:

- Bị bỏ qua bởi hầu hết các trình thu thập thông tin chính hoặc được diễn giải theo nhiều cách khác nhau (trong trường hợp trì hoãn thu thập thông tin)

- Được tạo dự phòng bằng các công cụ như Google Search Console (cho sơ đồ trang web)

Tùy chỉnh Robots.txt theo từng trường hợp.

Chúng ta hãy đi qua 1 số ít trường hợp sử dụng đơn cử để cho bạn thấy làm thế nào toàn bộ phối hợp với nhau .

Cách sử dụng Robots.txt để chặn truy cập vào trang web toàn bộ của bạn

Giả sử bạn muốn chặn tất cả quyền truy cập trình thu thập thông tin vào trang web của mình. Điều này dường thường áp dụng cho một trang web mới phát triển, bạn sẽ không muốn Google hay Bing index những nội dung tạm thời của bạn đâu, vì sau khi bạn cập nhật nội dung mới bạn sẽ nhận được hàng tá các yêu cầu xử lý lỗi 404… Để làm điều đó, bạn sẽ thêm mã này vào tệp robots.txt của WordPress:

User-agent: *

Disallow: /Điều gì đang xảy ra trong mã đó ?

Dấu sao (*) bên cạnh User-agent là ký tự đại diện, có nghĩa là nó áp dụng cho mọi User-agent. Dấu gạch chéo bên cạnh Disallow nói rằng bạn không cho phép truy cập vào tất cả các trang có chứa “tenmiencuaban.com/” (đó là trang duy nhất trên trang web của bạn).

Cách sử dụng Robots.txt để chặn một Bot truy cập trang web của bạn

Trong ví dụ này, tôi sẽ giả vờ rằng bạn không thích việc Bing thu thập dữ liệu các trang của bạn. Bạn đang cố gắng để Google index càng nhiều càng tốt và thậm chí không muốn Bing nhìn vào trang web của bạn. Để chỉ chặn Bing thu thập dữ liệu trang web của bạn, bạn sẽ thay dấu sao (*) bằng Bingbot:

User-agent: Bingbot

Disallow: /Về cơ bản, đoạn mã trên nói rằng chỉ áp dụng quy tắc Disallow cho các bot với User-agent là Bing Bingbot . Bây giờ, bạn không muốn chặn truy cập vào Bing – nhưng kịch bản này sẽ có ích nếu có một bot cụ thể mà bạn không muốn truy cập trang web của mình.

Cách sử dụng Robots.txt để chặn truy cập vào một thư mục hoặc tệp cụ thể

Trong ví dụ này, giả sử rằng bạn chỉ muốn chặn quyền truy vấn vào một tệp hoặc thư mục đơn cử ( và tổng thể những thư mục con của thư mục đó ). Để vận dụng điều này cho WordPress, giả sử bạn muốn chặn :

- Toàn bộ thư mục wp-admin

- wp-login.php

Bạn hoàn toàn có thể sử dụng những lệnh sau :

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-login.phpCách sử dụng Robots.txt để cho phép truy cập vào một tệp cụ thể trong thư mục không được phép

Bây giờ hãy nói rằng bạn muốn chặn toàn bộ thư mục, nhưng bạn vẫn muốn cho phép truy cập vào một tệp cụ thể trong thư mục đó. Đây là nơi lệnh Disallow có ích, và nó thực sự rất phù hợp với WordPress. Trên thực tế, tệp robot.txt ảo của WordPress minh họa hoàn hảo ví dụ này:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpĐoạn này chặn truy cập vào toàn bộ / wp-admin / thư mục trừ các /wp-admin/admin-ajax.php tập tin.

Cách sử dụng Robots.txt để ngăn chặn Bots thu thập dữ liệu kết quả tìm kiếm WordPress

Một tinh chỉnh dành riêng cho WordPress mà bạn có thể muốn thực hiện là ngăn các trình thu thập tìm kiếm thu thập dữ liệu các trang kết quả tìm kiếm của bạn. Theo mặc định, WordPress sử dụng tham số truy vấn tên? S =. Vì vậy, để chặn truy cập, tất cả những gì bạn cần làm là thêm quy tắc sau:

Xem thêm: Hướng dẫn làm robot bằng giấy siêu đẹp

User-agent: *

Disallow: /?s=

Disallow: /search/Cách tạo các quy tắc khác nhau cho các Bots khác nhau trong Robots.txt

Cho đến bây giờ, tất cả các ví dụ đã xử lý một quy tắc tại một thời điểm. Nhưng nếu bạn muốn áp dụng các quy tắc khác nhau cho các bot khác nhau thì sao? Bạn chỉ cần thêm từng bộ quy tắc theo khai báo Tác nhân người dùng cho mỗi bot. Ví dụ: nếu bạn muốn tạo một quy tắc áp dụng cho tất cả các bot và quy tắc khác áp dụng cho chỉ Bingbot , bạn có thể thực hiện như sau:

User-agent: *

Disallow: /wp-admin/

User-agent: Bingbot

Disallow: /Trong ví dụ này, tất cả các bot sẽ bị chặn truy cập / wp-admin /, nhưng Bingbot sẽ bị chặn truy cập toàn bộ trang web của bạn.

Kết luận

Như vậy là bạn đã hiểu rõ tính năng của robots.txt trong SEO Onpage, cách để tạo ra một file robots.txt cho webite và tùy chỉnh file robots.txt theo ý muốn rồi phải không nào. Việc vấu hình sai file robots.txt hoàn toàn có thể dẫn tới nhiều yếu tố về thu thập dữ liệu trên những công cụ tìm kiếm vì thế hãy cẩn trọng trước khi chỉnh gì đó nhé, chúc những bạn thành công xuất sắc .

Source: https://sangtaotrongtamtay.vn

Category: Công nghệ

Để lại một bình luận